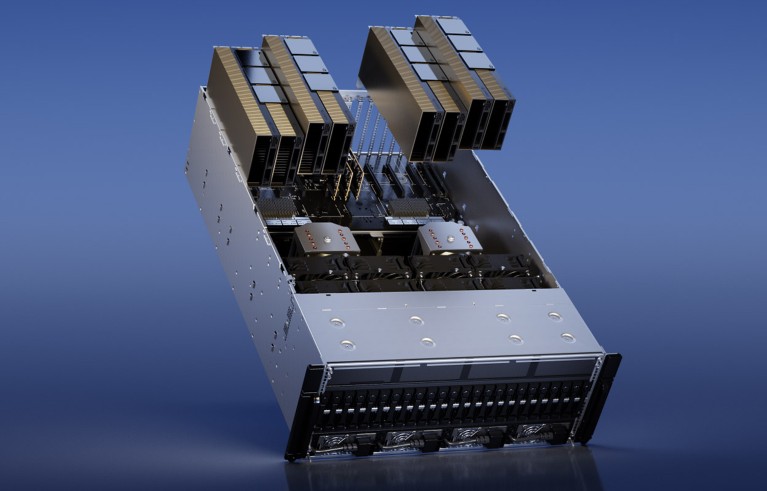

Unit pemrosesan grafis H100 raksasa teknologi NVIDIA adalah chip yang banyak dicari untuk penelitian kecerdasan buatan.Kredit: NVIDIA

Banyak ilmuwan universitas merasa frustrasi dengan terbatasnya daya komputasi yang tersedia bagi mereka untuk penelitian kecerdasan buatan (AI), menurut survei terhadap akademisi di puluhan institusi di seluruh dunia.

Bagaimana mesin pencari sains yang didukung AI dapat mempercepat penelitian Anda

Temuannya1yang diposting ke server pracetak arXiv pada tanggal 30 Oktober, menunjukkan bahwa akademisi tidak memiliki akses ke sistem komputasi paling canggih. Hal ini dapat menghambat kemampuan mereka untuk mengembangkan model bahasa besar (LLM) dan melakukan penelitian AI lainnya.

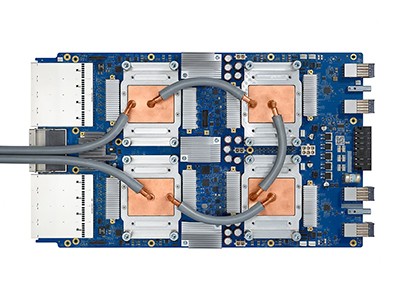

Secara khusus, peneliti akademis terkadang tidak memiliki sumber daya untuk memperoleh unit pemrosesan grafis (GPU) yang cukup kuat — chip komputer yang biasa digunakan untuk melatih model AI yang harganya bisa mencapai ribuan dolar. Sebaliknya, peneliti di perusahaan teknologi besar memiliki anggaran lebih tinggi dan dapat membelanjakan lebih banyak uang untuk GPU. “Setiap GPU menambah lebih banyak daya,” kata rekan penulis studi Apoorv Khandelwal, seorang ilmuwan komputer di Brown University di Providence, Rhode Island. “Meskipun raksasa industri tersebut mungkin memiliki ribuan GPU, akademisi mungkin hanya memiliki sedikit.”

Bagaimana chip komputer mutakhir mempercepat revolusi AI

“Kesenjangan antara model akademis dan industri sangat besar, namun bisa jadi jauh lebih kecil,” kata Stella Biderman, direktur eksekutif di EleutherAI, sebuah lembaga penelitian AI nirlaba di Washington DC. Penelitian mengenai kesenjangan ini “sangat penting”, katanya.

Menunggu lama

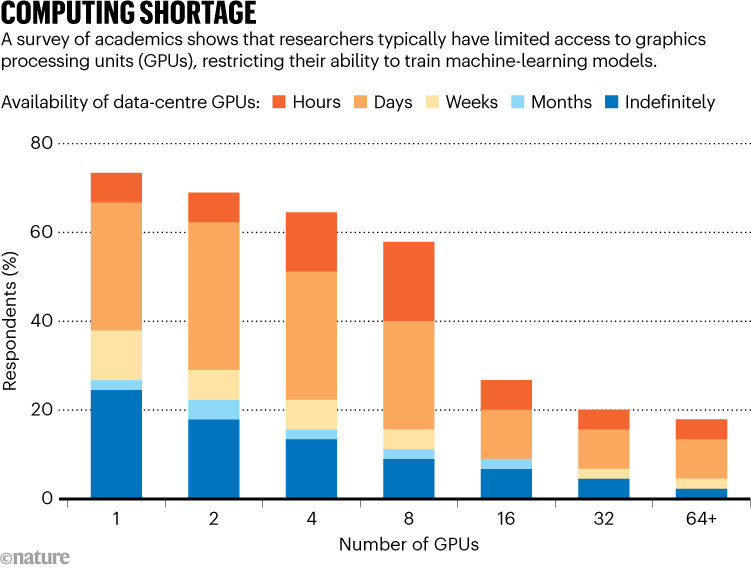

Untuk menilai sumber daya komputasi yang tersedia bagi akademisi, Khandelwal dan rekan-rekannya mensurvei 50 ilmuwan di 35 institusi. Dari responden, 66% menilai kepuasan mereka terhadap daya komputasi adalah 3 atau kurang dari 5. “Mereka sama sekali tidak puas,” kata Khandelwal.

Universitas memiliki beragam pengaturan untuk akses GPU. Beberapa mungkin memiliki cluster komputasi pusat yang digunakan bersama oleh departemen dan mahasiswa, tempat peneliti dapat meminta waktu GPU. Institusi lain mungkin membeli mesin untuk digunakan secara langsung oleh anggota lab.

Sumber: Ref. 1

Beberapa ilmuwan mengatakan bahwa mereka harus menunggu berhari-hari untuk mengakses GPU, dan mencatat bahwa waktu tunggu sangat tinggi menjelang tenggat waktu proyek (lihat ‘Kekurangan komputasi’). Hasil penelitian ini juga menyoroti kesenjangan akses global. Misalnya, salah satu responden menyebutkan sulitnya menemukan GPU di Timur Tengah. Hanya 10% dari mereka yang disurvei mengatakan bahwa mereka memiliki akses ke GPU NVIDIA H100, chip canggih yang dirancang untuk penelitian AI.

Hambatan ini menjadikan proses pra-pelatihan – yang memberikan sejumlah besar data kepada LLM – menjadi sangat menantang. “Ini sangat mahal sehingga sebagian besar akademisi bahkan tidak mempertimbangkan untuk melakukan sains sebelum pelatihan,” kata Khandelwal. Dia dan rekan-rekannya berpendapat bahwa akademisi memberikan perspektif unik dalam penelitian AI, dan kurangnya akses terhadap daya komputasi dapat membatasi bidang ini.

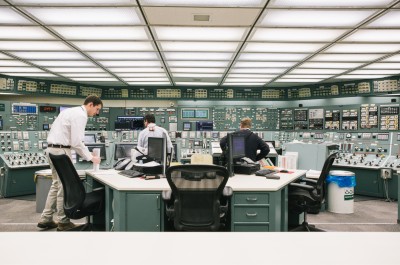

Tenaga nuklir untuk AI: apa yang diperlukan untuk membuka kembali Three Mile Island dengan aman

“Sangat penting untuk memiliki lingkungan penelitian akademis yang sehat dan kompetitif untuk pertumbuhan jangka panjang dan pengembangan teknologi jangka panjang,” kata rekan penulis Ellie Pavlick, yang mempelajari ilmu komputer dan linguistik di Brown University. “Ketika Anda memiliki riset industri, terdapat tekanan komersial yang jelas dan hal ini terkadang memberikan insentif untuk melakukan eksploitasi lebih cepat dan melakukan eksplorasi lebih sedikit.”

Metode yang efisien

Para peneliti juga menyelidiki bagaimana akademisi dapat memanfaatkan sumber daya komputasi yang kurang bertenaga dengan lebih baik. Mereka menghitung waktu yang diperlukan untuk melakukan pra-pelatihan beberapa LLM menggunakan perangkat keras dengan sumber daya rendah — dengan antara 1 dan 8 GPU. Meskipun sumber dayanya terbatas, para peneliti berhasil melatih banyak model, meskipun membutuhkan waktu lebih lama dan mengharuskan mereka mengadopsi metode yang lebih efisien.

Model AI yang menggunakan data yang dihasilkan AI dengan cepat mengeluarkan omong kosong

“Kami sebenarnya bisa menggunakan GPU yang kami miliki lebih lama, sehingga kami bisa mengimbangi beberapa perbedaan yang ada di industri,” kata Khandelwal.

“Sangat menyenangkan melihat Anda sebenarnya dapat melatih model yang lebih besar daripada yang diperkirakan banyak orang dengan sumber daya komputasi yang terbatas,” kata Ji-Ung Lee, yang mempelajari model neuroexplicit di Saarland University di Saarbrücken, Jerman. Dia menambahkan bahwa penelitian di masa depan dapat melihat pengalaman para peneliti industri di perusahaan kecil, yang juga kesulitan dengan akses terhadap sumber daya komputasi. “Tidak semua orang yang memiliki akses ke komputasi tanpa batas bisa mendapatkannya,” katanya.